Nói tiếp, mình cũng từng chia sẻ là việc Mỹ cấm vận GPU hiệu suất cao đối với TQ đã khiến TQ đi một con đường nguy hiểm hơn mà Mỹ không kiểm soát được, đó là tận dụng phong trào AI nguồn mở mà Meta của Mắc dẫn đầu để phát triển các mô hình AI Nguồn Mở Quy Mô Nhỏ (Small Language Model) được chuyên biệt hoá chức năng, và sử dụng được trên các thiết bị AI ở Local như dùng card GPU gaming RTX là đủ chạy hoặc chạy được trên mấy con Raspberry Pi hoặc chạy được trên điện thoại có chip NPU (Neural Processing Unit – chip chạy AI yếu hơn GPU nhưng vẫn chạy ổn). Sếp của Trung tâm AI Facebook (FAIR) giáo sư Yann LeCun có post cái tút confirm về ý này khi DeepSeek bùng nổ, DeepSeek sử dụng mô hình nguồn mở LLaMA của Meta cho việc huấn luyện AI DeepSeek.

Người Trung Quốc từ lúc mở cửa năm 1978 đến nay, luôn tập trung vào việc “làm sao để sản xuất lớn nhanh nhất nhiều nhất”, trái ngược với người Mỹ, là làm sao để pump market cap lên maximum có thể tức là khai mở thị trường lên đến cực hạn. Đây chính là điểm khiến Mỹ phải thương chiến với TQ, nghĩ coi mình thì lo mở rộng thị trường, nhưng thằng lòi bên kia đại dương chỉ chăm chăm lo ăn sao cho lớn vô miếng bánh mà mình mất công mở 😃)))) cáu vl 😃)))

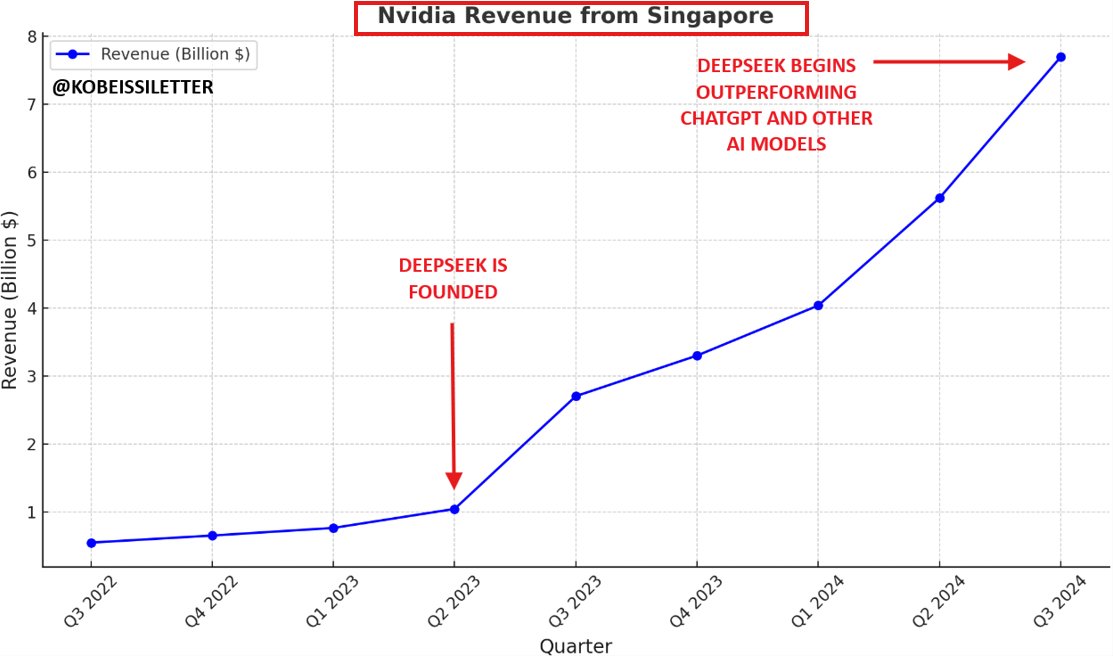

Nên anh Trump mới cấm vận TQ, rồi cấm vận chip đối với TQ, mục tiêu là để ép và ngăn TQ cắn vô thị trường mà mấy anh Mỹ tốn công mở mà chưa kịp ăn. Âu là do bản chất cách làm ăn mấy trăm năm nay của 2 đế quốc thôi.

DeepSeek thể hiện rõ lối làm ăn theo hướng tập trung tối ưu đó của TQ ngay từ cách thức tổ chức công ty, team DeepSeek có dưới 200 người, nghề chính lại còn không phải là làm AI, mà là cty con của Cty quản lý quỹ đầu tư kỹ thuật (Quant Fund) High-Flyer, đám làm AI này dùng đám card thừa khi cty mẹ xài chạy mấy model financial xong thì xài, đặc biệt là team này ếu có ông PhD nào nữa, nhân sự cốt cán của team toàn là cử nhân thôi, lại còn đến từ các trường đại học chả phải top đầu như Thanh Hoa hay Bắc Đại nữa 😃)) Nên sản phẩm DeepSeek AI của họ dĩ nhiên là hướng tới tối ưu ngay từ đầu, chi phí sao cho rẻ nhất, bán được đại trà nhất, cắn vô to nhất miếng bánh AI mà người Mỹ đã pump lên 800% chỉ trong 2 năm.

Tóm lại nói dông dài về mặt kinh tế, tài chính và địa chính trị, để nói rõ tổng quan rằng người Mỹ đã ép người Trung Quốc tới điểm “cùng tất biến” nên DeepSeek là kết quả nhãn tiền của chính sách o ép từ Mỹ thôi

Dù mình làm cho cty AI Mỹ nhưng mình cũng ếu ưa cái chính sách cấm vận chip này của Mỹ mỗi lần train model AI phải connect qua GPUs farm của cty bên Mỹ khổ bỏ mie

DeepSeek V3 là Mô hình Ngôn Ngữ Lớn (LLM) là nền tảng để train nên mô hình DeepSeek R1 là Mô Hình Tư Duy Lý Luận (Reasoning Model)

1. Mô hình nhỏ (Small Language Model) nhưng hiệu quả cao !

DeepSeek là mô hình sử dụng cấu trúc Mixture-of-Experts (MoE) tức là trong 1 Mô hình AI chứa nhiều Mô hình AI nhỏ (mỗi AI nhỏ gọi là Chuyên Gia, được huấn luyện riêng biệt có chức năng kiến thức riêng biệt) , nên kích thước tổng của DeepSeek là 671B Tỉ Tham Số là AI Rất TO nhưng thực tế lúc chạy chỉ có 37B Tỉ Tham Số tức phần thực sự chiếm bộ nhớ của GPUs lại chỉ là AI nhỏ, tỉ lệ expert trên tổng kích thước là 1/18 , một tỉ lệ rất đáng kinh ngạc vì thông thường tỉ lệ này ở các mô hình AI khác dùng MoE trung bình tầm 1/7 thôi. Chứng tỏ DeepSeek đã đẩy kỹ thuật Mixture-of-Experts tới một ngưỡng mới, trước đó mấy mô hình AI khác mà dùng MoE mỗi lần hỏi AI phải gọi lên rất đông ông experts. Kỹ thuật MoE không phải kỹ thuật mới, GPT-4 bản chất đã là mô hình 1000B tỉ tham số nhưng theo kiến trúc MoE với tỉ lệ gọi expert trên tổng tham số là 1/3 lận

Trên paper của DeepSeek cũng nói rằng họ có kiến trúc MoE riêng gọi là DeepSeekMoE, kiến trúc này tiết kiệm bộ nhớ vì nó có những ông là Shared Expert tức là ổng có Kiến Thức Chung của 2 nhóm khác nhau nên khi User hỏi những câu hỏi cần kiến thức đến từ nhiều ông Expert thì mấy ông Expert chung này giúp tiết kiệm bộ nhớ so với 1 ông Expert kiến thức riêng rẽ 😃)))) Có một số tối ưu về thuật toán routing nên gọi ông Expert nào lên nữa, tóm lại DeepSeekMoE giúp Mô Hình To nhưng chạy như Mô Hình Nhỏ, nên hiệu suất là của Mô Hình To trong khi xài tài nguyên thì như Mô Hình Nhỏ. Bạn đọc paper DeepSeekMoE để hiểu rõ hơn nha, khá hay đó.

2. Tiết kiệm GPUs vRAM

vRAM của GPUs thực tế là thứ luôn bị thiếu, những nhà khoa học huấn luyện AI luôn thiếu nhất là thiếu vRAM do đặc tính của mô hình AI là gia tăng mức độ chiếm dụng vRAM theo theo cấp số mũ (quadratic), nên mấy ông làm AI phải mua mấy con card GPUs đắt đỏ của Nvidia, càng đắt thì vRAM càng cao, card H100 tới 80GB ram lận, bọn Nvidia rất khốn nạn khi chúng nó rất tiết kiệm vRAM gắn trên card dù chúng có thể làm nhiều hơn, nhưng éo, làm tiền max khung luôn. Các nhà khoa học nghèo ở những nước bị cấm vận mua GPU xịn của Nvidia như Trung Quốc, hay Việt Nam đều rất khó khăn với việc có thêm vRAM để chạy AI hay huấn luyện AI

Do đó DeepSeek đã tiến một bước đột phá nữa khá xa trong việc tiết kiệm vRAM phải dùng bằng việc phát minh ra thuật toán Multi-Head Latent Attention cách mạng so với thuật toán Attention gốc mà Google phát minh ra lúc đưa ra thuật toán Transformer huyền thoại tạo nên LLM hiện nay đó, cách mạng hơn cả thuật toán Flash-Attention (cũng của Google phát minh) mà các mô hình AI hiện nay dùng để tiết kiệm bộ nhớ vRAM.

Giải thích dễ hiểu kỹ thuật này là họ phát minh ra một thuật toán giúp nén dữ liệu kiến thức của Mô Hình AI 😃)))) hay chưa 😃))

Bản thân AI Model đã là sự nén kiến thức rồi, nhưng họ còn tìm ra cách nén tốt hơn nữa, nén nhỏ hơn 1/4 so với kích thước gốc , giảm tới gần 80% bộ nhớ vRAM phải sử dụng lận

Hai cái đột phá về công nghệ ở trên đều được DeepSeek giới thiệu từ 8 tháng trước, chúng là sự chuẩn bị cho sự ra đời của mô hình DeepSeek R1 làm mưa làm gió 3 hôm nay

Đây là 2 kỹ thuật chính khiến cho chi phí huấn luyện AI của DeepSeek thật sự rẻ hơn so với OpenAI, Google hay bất kỳ ông làm mô hình AI nào hiện nay của Mỹ. Cốt lõi là tiết kiệm vRAM thôi 😃)) tiết kiệm được vRAM thì có thể mua card rẻ hơn thay vì phải mua card đắt vốn khó mua nữa, chưa kể còn có thể tận dụng đám card cũ nữa 😃))) nên DeepSeek mới có thể nhẹ nhàng thổi bay 10% (600 tỉ đô) giá trị của Nvidia chỉ trong 1 ngày, cái mà nhà đầu tư NVDA sợ nhất là bọn làm AI không mua card mới nữa mà đi mua card cũ về chạy AI 😃))) bể mie cái mô hình kinh doanh card dựa trên vRAM ít và đắt đỏ của anh Jesen Huang rồi.

Dĩ nhiên, bạn có thể làm toán một chút để thấy rằng so với mô hình AI khác thì DeepSeek giảm trung bình khoảng 50-60% số lượng vRAM sử dụng

Vậy chi phí phần cứng huấn luyện AI maybe có thể giảm tương ứng con số 50-60% so với mô hình khác 😃)))))

Tới đây thì cá nhân mình cho rằng con số 5 triệu đô huấn luyện DeepSeek R1 so với 100 triệu đô huấn luyện OpenAI GPT-4 tức giảm tới 95% chi phí thì nó … hơi xạo xạo kiểu dựng chuyện con nhà nghèo học giỏi nên nó đáng được ngưỡng mộ mấy anh TQ thì hay quá lời kiểu này mà

3. Kỹ thuật huấn luyện AI Tư Duy Lý Luận rất đột phá

Paper của model DeepSeek R1 mô tả rõ quy trình huấn luyện R1 rất đột phá.

Đầu tiên, DeepSeek bắt đầu huấn luyện Reasoning luôn bằng kỹ thuật Reinforcement Learning (RL) luôn chứ không dùng kỹ thuật Supervised Learning (SL)

Giải thích dễ hiểu là các bên khác huấn luyện năng lực Reasoning cho AI thì bắt đầu bằng việc thuê cty Scale AI rồi cty này thuê người về, rồi những người này sẽ Viết Ra: Mẫu-Câu Hỏi-Mẫu Tư Duy Lý Luận-Mẫu Câu Trả Lời . Viết tầm vài trăm ngàn mẫu rồi lấy vài trăm ngàn mẫu này đi training AI 😃))) tức là AI sẽ học từ con người Dĩ nhiên chi phí thuê người viết mấy trăm ngàn mẫu này nó mắc chứ không rẻ, vì bọn người mà viết được Tư Duy Lý Luận từng bước một cách khúc chiết rõ ràng trước khi trả lời thì bọn đấy có học hành cao ấy

Nên DeepSeek mới làm luôn là prompt cho mô hình LLM DeepSeek V3 trực tiếp thử “Thinking-Step-by-Step” viết ra từng bước suy nghĩ trước khi trả lời, rồi lập trình một thuật toán lựa ra các câu trả lời mà Mô hình AI LLM DeepSeek V3 sinh ra hay nhất, có các bước Tư Duy Lý Luận Rõ Ràng Khúc Chiết Nhất, thì đánh điểm cao và thưởng cho AI (Reward Model), dần dần AI DeepSeek học được cách Reasoning một cách hiệu quả MÀ KHÔNG CẦN CON NGƯỜI DẠY.

Và như thế vẫn chưa hết cái hay, trong quá trình DeepSeek tự dạy mình học Reasoning nó đã TỰ NHẬN THỨC ĐƯỢC việc phải TỰ ĐÁNH GIÁ LẠI Lý Luận Mà Nó Đã Viết rồi TỰ CHỈNH SỬA NẾU THẤY NÓ KHÔNG HỢP LOGIC !!!

Đây được giới khoa học AI gọi là Aha Moment 😃))) còn giới chuyên gia kol thì gào lên là “Bỏ Mẹ Rồi AI Tự Nhận Thức Tự Sửa Lỗi Được Rồi, Skynet comingggggggg” 😃)))

Sau khi huấn luyện xong mô hình DeepSeek V3 có năng lực Reasoning gọi là DeepSeek R1-Zero thì DeepSeek nhận ra là mô hình này reasoning thì hay nhưng nó không biết kết luận nên đưa ra câu trả lời trớt qướt dù reasoning rõ hay 😃))))

Nên DeepSeek bắt đầu fine-tuning mô hình R1-Zero hướng vô một số nhóm nghành cụ thể như Toán, Khoa Học, Logic, Viết Code, Lập Trình … để câu trả lời nó thực tế hơn. VÀ họ có sử dụng con người tham gia đánh giá câu trả lời từ AI để tối ưu câu trả lời sao cho con người đọc hiểu được 😃))) đây rõ ràng là kỹ thuật Re-inforcement Learning by Human Feedback (RLHF) rất truyền thống để huấn luyện AI LLM.

Nên chỗ này họ có tiết kiệm chi phí thuê người tham gia quá trình huấn luyện đấy nhưng vẫn phải chi, không nhiều thôi 😃)))

4. Sử dụng dữ liệu tổng hợp (Synthetic Data) từ OpenAI

DeepSeek không nói trong paper nhưng giới khoa học AI đã tìm ra các manh mối rằng DeepSeek sử dụng dữ liệu sinh ra bởi AI của OpenAI để hỗ trợ cho quá trình huấn luyện bằng kỹ thuật RLHF. Do để tiết kiệm chi phí nên số người tham gia feedback-loop để kiểm định và điều chỉnh câu trả lời của AI DeepSeek trong giai đoạn cuối của việc huấn luyện là không nhiều, nên DeepSeek có sử dụng lượng lớn dữ liệu Hỏi-Đáp sinh ra từ AI của OpenAI để điều chỉnh câu trả lời của mô hình sau công đoạn Reasonin, giúp câu trả lời “thật hơn” như … OpenAI GPT 😃))))

Thậm chí ở phrase đầu khi cho mô hình AI tự học kỹ thuật Reasoning thì DeepSeek đã sử dụng dữ liệu tổng hợp từ LLaMA của Meta để làm prompt chỉ dẫn cho DeepSeek V3 có thể tự sinh chuỗi Reasoning.

Tóm lại DeepSeek dùng dữ liệu tổng hợp để giảm chi phí làm dataset training cho AI. Nhưng cái hay là họ chứng minh luận điểm rằng dùng AI dạy AI sẽ làm mô hình AI bị thoái hoá và ngu đi thay vì khôn lên LÀ SAI 😃))))

5. Họ cung cấp Open Source luôn mô hình DeepSeek R1

Đây không phải đột phá kỹ thuật nhưng đột phá về mặt kinh doanh. Khi họ cho open source mô hình DeepSeek R1 thì họ mở ra hẳn một business ecosystem mới xoay quanh mô hình DeepSeek mà họ cung cấp, mọi người có thể tải mô hình về, mua card hay thuê card từ Nvidia để chạy AI DeepSeek. DeepSeek sẽ không phải tốn chi phí vận hành hạ tầng khổng lồ để cung cấp API cho mọi người như các mô hình đóng như OpenAI, Google hay Anthropic.

NHƯNG nếu bạn muốn chỉnh sửa mô hình DeepSeek R1 hoặc sao chép nó thì không

DeepSeek không cung cấp chi tiết về cách tạo Dataset – tức dữ liệu huấn luyện nên DeepSeek V3 và R1

DeepSeek không cung cấp chi tiết về thuật toán Group Relative Policy Optimization (GRPO) và các thuật toán liên quan dùng để đánh giá câu trả lời reasoning của AI

Trong ngành AI, dataset và các thuật toán dùng trong quá trình training mới là key turning point.

Không có chúng bạn không thể sao chép hoặc fine-tune mô hình DeepSeek R1 đạt hiệu quả như DeepSeek đang làm.

Soon thôi, DeepSeek sẽ bán các dịch vụ xoay quanh các mô hình Open Source này như fine-tuning…

Nên mình mới nói là DeepSeek open-source chỉ 1 phần thôi, không hẳn là fully open-source đâu

Đây chính là điểm đăc biệt, chúng ta có thể tận dụng DeepSeek V3 và R1 để cung cấp các dịch vụ Local AI

DeepSeek rất khéo khi cung cấp cho chúng ta một số mô hình R1 phiên bản nhỏ xíu 1B,7B,8B,14B,32B,70B là dạng thu nhỏ từ các mô hình AI nguồn mở khác như Qwen của Alibaba, LLaMA của Meta.

Các mô hình nhỏ xíu này thậm chí chạy trược trên điện thoại hay máy tính laptop bình thường của bạn 😃)))

Đây chính là điểm bùng nổ các Sản phẩm & Dịch vụ Ứng dụng AI chạy Local với DeepSeek AI đặc biệt là AI Agent sẽ dễ dàng triển khai hơn khi có năng lực Reasoning của DeepSeek R1

Cuối tháng 2 tới Conductify AI sẽ cung cấp khoá học tạo AI Agent cho Cá Nhân và hệ thống chạy AI Agent Local ngay trên máy tính của bạn sử dụng DeepSeek R1

Thời AI Agent chạy đầy đường tới rồi !!! cám ơn người anh em Trung Hoa DeepSeek AI 😃)))))))